Fino al secolo scorso rilevare un’architettura era sinonimo di una lenta operazione di misurazione con l’aiuto di squadre, cordelle, triplometri. La macchina fotografica, poi, poteva svolgere un ruolo ausiliario, per registrare immagini che sarebbero servite all’operatore per integrare gli eidotipi (schizzi eseguiti a mano libera da esperti disegnatori davanti al manufatto) con la messa in pulito dei disegni. L’abilità del rilevatore permetteva di ridurre al minimo gli errori, ma l’approssimazione era comunque fatta quasi sempre al centimetro, per cui ulteriori aggiustamenti venivano eseguiti una volta terminata la fase di campagna con il rientro in studio e l’organizzazione dei vari elaborati grafici di base.

Tutto ci permetteva comunque di ottenere materiale di grande qualità, se l’attenzione era riposta nella delicatissima fase di raccolta delle informazioni: si pensi agli schizzi di rilievo di Andrea Palladio, Antonio da Sangallo il giovane o di Baldassarre Peruzzi, che con grande accuratezza hanno misurato e disegnato i più piccoli particolari dei resti della Roma antica.

Pur utilizzando strumentazione tecnica di tipo ottico per la misurazione degli angoli, quale probabilmente il teodolite, il cui nome di derivazione araba è al idat o qualcosa di simile, potevano con buona approssimazione ottenere quote di punti inaccessibili, come altezze di edifici e planimetrie urbane. La pianta di Roma di Raffaello Sanzio, più volte studiata e analizzata, documenta un’alta qualità di lavoro, oltre a una precisione elevata, confermata dalla destrezza dell’artista nelle sue opere pittoriche.

Con l’introduzione delle tecnologie elettroniche nell’ultimo trentennio del Novecento, si pensi al distanziometro laser, ma anche al teodolite, l’accuratezza comincia a essere maggiore e il rilievo più oggettivo. La stazione totale, unione di misuratore di angoli e di distanza tra punti, restituisce un insieme di dati che poteva essere gestito anche attraverso vari software.

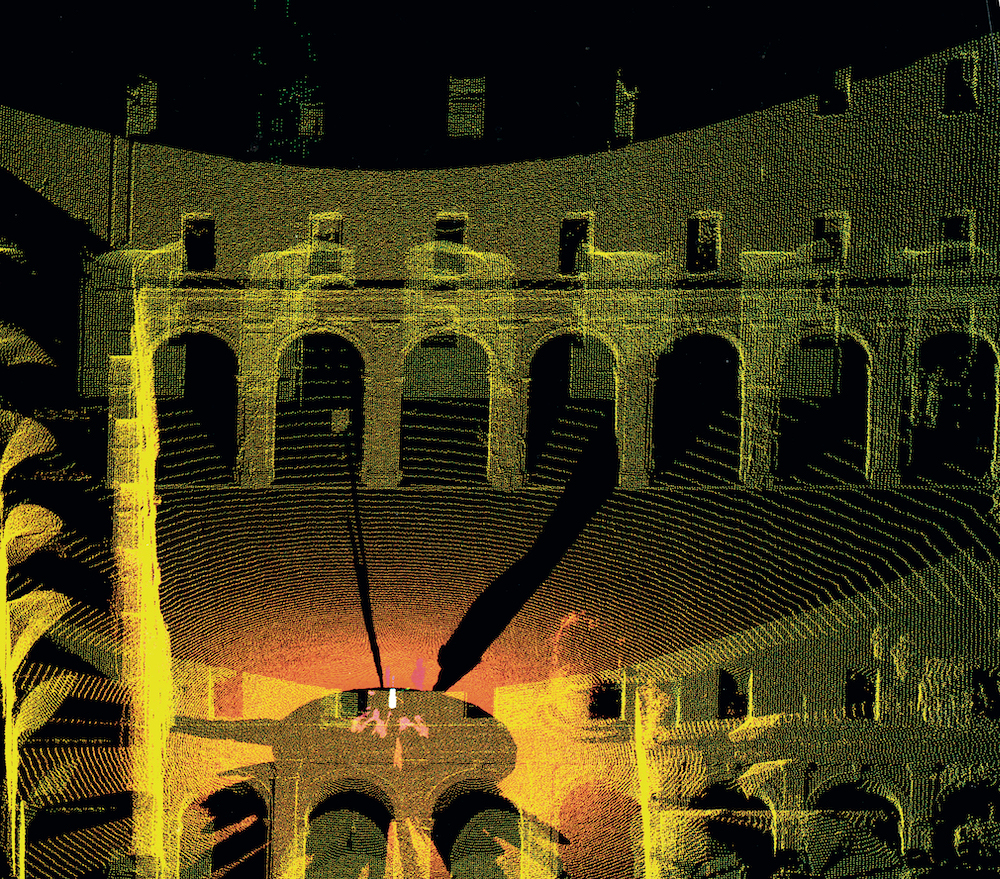

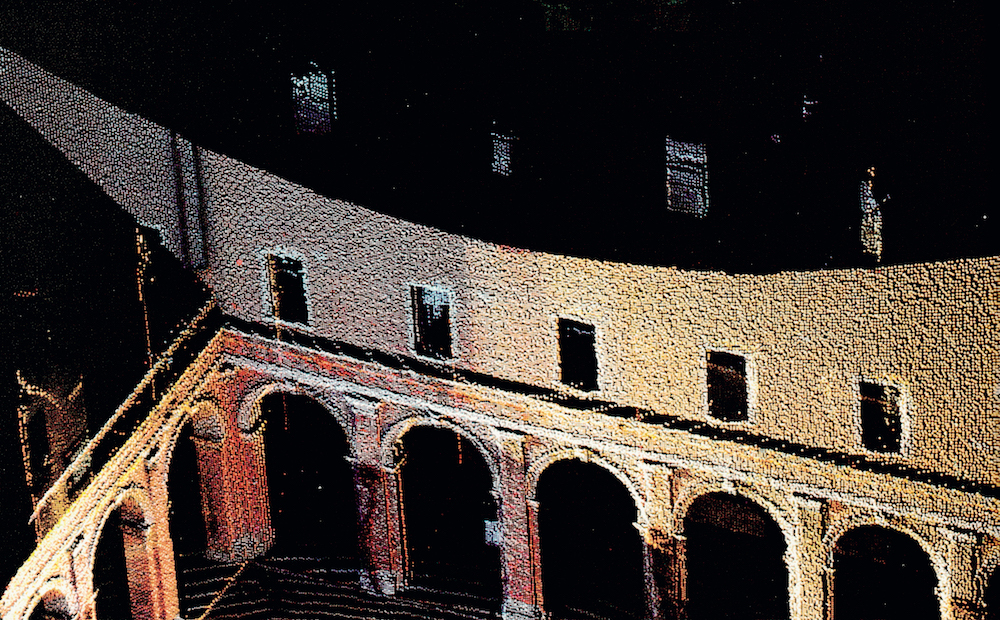

L’introduzione di sistemi Cad tra gli anni Ottanta e Novanta dello scorso secolo, ha permesso di vedere punti luminosi su monitor che venivano uniti come avviene nei giochi di enigmografia, in cui il disegnatore ricompone la figura celata collegando punti numerati in sequenza. Ma, mentre l’acquisizione della stazione totale era sostanzialmente gestita da un operatore che mirava a punti significativi da rilevare (uno spigolo di una finestra, un’estremità di una facciata, un’intersezione di linee) lo scanner 3D ha introdotto l’automatismo. Il meccanismo rotatorio automatizzato, infatti, prevede l’acquisizione a tutto campo di punti della scena, in modo che nel giro di pochi minuti siano registrate enormi masse di dati, nell’ordine di milioni di punti, che non a caso sono chiamati «nuvole di punti».

Con il tempo, il campionamento di questi pixel spaziali, con coordinate tridimensionali, ha permesso l’annotazione del valore cromatico, differenziato in due differenti tipologie: da un lato la visualizzazione in falsi colori per sottolineare la distanza del punto dallo strumento di rilevamento e, quindi, la qualità del dato. Dall’altro il colore effettivo, modalità truecolor, del materiale che veniva acquisito, in modo da assicurarsi la restituzione della copia esatta, un effettivo clone digitale, del manufatto oggetto di indagine.

Questo sostanziale cambiamento nell’attività di rilievo è stato registrato anche nel documento Dichiarazione sul rilevamento architettonico del novembre 2000, in cui si fa esplicito riferimento alla costruzione di un modello tridimensionale semplificato che, grazie alle sue caratteristiche digitali, può essere facilmente interrogato per avere informazioni su dati metrici, geometrici, figurativi, strutturali, oltre a informazioni sui materiali, le tecniche costruttive, il degrado fisico.

Proprio questi ultimi aspetti, infatti, erano spesso registrati in maniera non corretta, grazie a integrazioni a mano libera sui disegni di prospetto, risultando difficili da controllare per quanto concerne le operazioni di risanamento e intervento diretto in fase di conservazione o restauro. Con il campionamento a scansione lineare al laser, il deterioramento della superficie viene a essere puntualmente registrato per ogni punto del modello, così da documentare nel tempo le operazioni condotte. Se pensiamo poi ad edifici con fessurazioni, lacerazioni, o sottoposti a dissesto ambientale (scosse telluriche, cedimenti strutturali, ecc.) possiamo riconoscere a questa nuova modalità operativa una valenza ulteriore: quella di monitorare il patrimonio edilizio in un intervallo temporale.

Sensori georeferenziati sono, infatti, in continuazione collocati su manufatti a rischio, in modo da inviare informazioni micrometriche che garantiscono un controllo strutturale indispensabile per la salvaguardia del bene e dei suoi abitanti, così da trasformare l’oggetto architettonico che andiamo a studiare, apparentemente statico, in un modello digitale dinamico, i cui piccoli spostamenti allertano i vari operatori che possono intervenire prontamente.

Se ogni edificio fosse sottoposto a controllo numerico con le tecnologie digitali ormai disponibili, si potrebbero evitare molti disastri dovuti a criticità costruttive o a scarsa/assente manutenzione. E forse anche lo straordinario ponte sul torrente Polcevera di Genova, realizzato da Riccardo Morandi ormai poco più di mezzo secolo fa, sarebbe ancora lì. A ricordarci sia la genialità del progettista, sia il fatto che i sensori presenti sulla struttura non devono per alcun motivo essere tolti, come avvenuto in questo caso, tra l’altro, ironia della sorte, proprio in occasione di lavori di manutenzione.

di Alberto Sdegno, Direttore del Master in Building Information Modeling presso l’Università di Udine (da YouBuild n.22)